AI Act: Approvato dal Parlamento Europeo la prima legge sull’Intelligenza Artificiale.

Cosa cambierà per le aziende?

Che quello dell’Intelligenza Artificiale sia un tema estremamente dibattuto e delicato non è certo una novità, fin dagli esordi infatti questa tecnologia così affascinante e innovativa ma allo stesso tempo non esente da rischi, ha destato molti dubbi e perplessità sia per gli addetti ai lavori, sia per gli utilizzatori finali.

L’UE ha deciso quindi di passare ai fatti, stilando una vera e propria normativa – prima al mondo – in grado di regolamentarne l’uso e l’abuso.

La proposta di legge, approvata lo scorso 14 giugno, si concentra principalmente sul rafforzamento delle norme relative alla qualità dei dati, alla trasparenza, alla supervisione umana e alla responsabilità. Inoltre prevede di affrontare le questioni etiche e le sfide di attuazione in vari settori, dalla sanità all’istruzione, dalla finanza all’energia.

Le norme stilate seguono infatti un approccio basato sul rischio e stabiliscono obblighi per i fornitori e per tutti coloro che impiegano sistemi di IA a seconda del livello di rischio che l’IA può generare.

Gli applicativi verranno infatti classificati per categorie di rischio e dovranno sottostare a rigorosi controlli.

Il livello di rischio massimo, stabilito dall’UE, è il “rischio inaccettabile” per la sicurezza delle persone, come ad esempio tutte le applicazioni utilizzate per il social scoring (classificazione delle persone in base al loro comportamento sociale o alle loro caratteristiche personali).

Il dibattito sul riconoscimento biometrico

Oggetto di forti discussioni è sicuramente il riconoscimento facciale, che con il nuovo testo viene definitivamente abolito in tutte le aree pubbliche, senza eccezione alcuna.

È stato infatti vietato per le IA qualunque uso intrusivo e discriminatorio, come:

- Identificazione biometrica remota “in tempo reale” e “a posteriori” in spazi accessibili al pubblico

- Sistemi di categorizzazione biometrica basati su caratteristiche sensibili (ad esempio genere, razza, etnia, cittadinanza, religione, orientamento politico)

- Sistemi di polizia predittiva (basati su profilazione, ubicazione o comportamenti criminali passati);

- Sistemi di riconoscimento delle emozioni utilizzati dalle forze dell’ordine, nella gestione delle frontiere, nel luogo di lavoro e negli istituti d’istruzione

- Estrazione non mirata di dati biometrici da Internet o da filmati di telecamere a circuito chiuso per creare database di riconoscimento facciale

Cosa accadrà alle aziende?

«L’Europa regola soprattutto le aziende produttrici di IA e a cascata quelle che la usano; queste devono accertarsi al meglio con le informazioni a loro disposizione che i sistemi IA sviluppati dai produttori siano conformi alle regole europee».

Spiega Stefano da Empoli, presidente dell’istituto di ricerca I-Com.

«Il principale impatto sulle imprese sta nel meccanismo previsto dall’approccio basato sul rischio che rappresenta l’architrave principale del provvedimento. In primo luogo, escludendo i relativamente pochi casi di proibizione assoluta, le imprese devono sincerarsi se la componente IA dei prodotti che vogliono immettere sul mercato sia contenuta nella ben più nutrita lista delle applicazioni ad alto rischio. Se questo è il caso, occorre procedere ad una valutazione di conformità che può essere svolta internamente oppure da un soggetto terzo certificato.»

I prodotti che supereranno i test di valutazione richiesti dalla legge AI appariranno sul mercato con un marchio di conformità CE (fisico o virtuale).

Fondamentale però sarà il monitoraggio post-vendita per identificare eventuali criticità non previste o inizialmente sottovalutate. Nel caso in cui poi, il produttore dovesse apportare delle sostanziali modifiche alla componente IA dell’applicativo, sarà necessaria una rivalutazione della conformità, consentendo alle autorità nazionali la corretta valutazione del rischio.

Conclusioni

Parola d’ordine trasparenza dunque: fondamentale per le aziende coinvolte, specie quelle ad alto rischio, sarà instituire un processo strutturato di IA governance, modificando il processo di compliance interno all’azienda e adottando soluzioni tecnologiche in grado di soddisfare il requisito di trasparenza algoritmica, interoperabilità, cyber security e non discriminazione.

Esplorando il Creative Coding: Liberare l’Arte attraverso il Codice

Esplorando il Creative Coding: Liberare l'Arte attraverso il Codice Nell'era digitale, la convergenza tra arte e tecnologia continua a sfidare i confini convenzionali, dando vita a nuove forme [...]

AlphaCodium: sfruttare l’AI Generativa per il Futuro del Coding

AlphaCodium: sfruttare l’AI Generativa per il Futuro del Coding Negli ultimi anni, l'intelligenza artificiale ha rivoluzionato molti aspetti della nostra vita quotidiana. Dall'assistenza virtuale alla guida autonoma, l'AI [...]

Cobol: l’highlander dell’era digitale

Cobol: l’highlander dell’era digitale Nel vasto panorama dei linguaggi di programmazione, ne esistono alcuni che resistono al passare del tempo, sfidando le mode e le tendenze del momento. [...]

L’Impatto delle Normative Digitali sull’Innovazione Aziendale

L'Impatto delle Normative Digitali sull'Innovazione Aziendale Negli ultimi anni, l'evoluzione digitale ha assunto un ruolo predominante nel plasmare il panorama normativo sia a livello italiano che europeo. Questa [...]

AIOps: La Rivoluzione nell’Operatività IT

AIOps: La Rivoluzione nell'Operatività IT Nel mondo tecnologico in rapida evoluzione, la complessità delle infrastrutture IT aziendali è aumentata in modo esponenziale. In risposta a questa sfida, è emersa [...]

Navigare nel Mondo dei Big Data: Guida tra Data Warehouse, Data Lake e Data Lakehouse

Navigare nel Mondo dei Big Data: Guida tra Data Warehouse, Data Lake e Data Lakehouse I Big Data rappresentano una risorsa preziosa per le aziende moderne, offrendo informazioni [...]

Cloud Global Trends 2023

Cloud Global Trends 2023 Il cloud ha rivoluzionato il modo e il contesto in cui operano le organizzazioni, fornendo soluzioni scalabili, modulabili e flessibili. I dati e le [...]

Truffe online d’estate: quali sono e i migliori consigli per evitarle

Truffe online d'estate: quali sono e i migliori consigli per evitarle Estate, tempo di vacanze, sole, mare, viaggi… certo, le ferie sono un momento di relax per tutti, ma [...]

AI Act: Approvato dal Parlamento Europeo la prima legge sull’Intelligenza Artificiale. Cosa cambierà per le aziende?

AI Act: Approvato dal Parlamento Europeo la prima legge sull’Intelligenza Artificiale. Cosa cambierà per le aziende? Che quello dell’Intelligenza Artificiale sia un tema estremamente dibattuto e delicato non è [...]

Decreto Fintech, primo via libera: tutte le novità

Decreto Fintech, primo via libera: tutte le novità Se il 2023 si è aperto con nuove interessanti sfide ed opportunità per il mondo delle Fintech, lo scorso mercoledì [...]

Attacco Ransomware in Italia: facciamo chiarezza

Attacco Ransomware in Italia: facciamo chiarezza Da ieri tutte le principali testate giornalistiche sono in pieno fermento: un massiccio attacco hacker, tramite un virus ormai tristemente noto alla cronaca [...]

Previsioni Fintech 2023: 10 sfide e tendenze per l’anno alle porte

Previsioni Fintech 2023: 10 sfide e tendenze per l’anno alle porte Quali saranno le sfide da affrontare e i principali trend per le Fintech nel 2023? Dal Politecnico di [...]

Sostenibile, resiliente e umano-centrica: ecco come sarà la quinta rivoluzione industriale

Sostenibile, resiliente e umano-centrica: ecco come sarà la quinta rivoluzione industriale Oggi non si parla più di Industria 4.0, ma di Industria 5.0, un nuovo modello produttivo, spesso [...]

Dalla remote revolution ai modelli di lavoro ibridi: luci e ombre del lavoro fluido

Dalla remote revolution ai modelli di lavoro ibridi: luci e ombre del lavoro fluido Come è cambiato il mondo del lavoro in questo ultimo anno e quali solo le [...]

IT Sostenibile: una scelta che conviene

IT Sostenibile: una scelta che conviene I modelli di economia circolare, tendenti allo zero waste, possono davvero essere applicati al mondo dell’ICT?E se sì, in che modo è possibile [...]

Ransomware: il lato oscuro del digitale non accenna ad arrestarsi

Ransomware: il lato oscuro del digitale non accenna ad arrestarsi In occasione della festività di Halloween, ci sembra appropriato dedicare un articolo ad uno dei “mostri” del digitale [...]

GDPR: Biden approva la tutela dei dati personali dei cittadini dell’Unione Europea

GDPR: Biden approva la tutela dei dati personali dei cittadini dell'Unione Europea Una notizia davvero storica per la tutela della privacy di tutti i cittadini europei che finalmente [...]

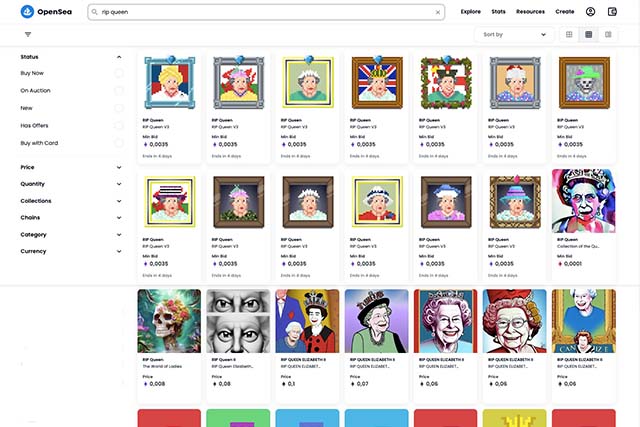

NFT e i ritratti della defunta Regina Elisabetta II: omaggio o speculazione?

NFT e i ritratti della defunta Regina Elisabetta II: omaggio o speculazione? Che anche il mondo dei Digital Asset non restasse indifferente alla morte della Regina Elisabetta II [...]

Inflazione e recessione non scoraggiano la spesa IT mondiale: da Gartner previsioni ottimistiche per il 2022

Inflazione e recessione non scoraggiano la spesa IT mondiale: da Gartner previsioni ottimistiche per il 2022 Previsioni ottimistiche per le spese previste in ambito IT nel 2022.Da un'analisi condotta dagli [...]

Explainable AI: l’intelligenza artificiale trasparente per le banche di domani

Explainable AI: l'intelligenza artificiale trasparente per le banche di domani Sfruttare le potenzialità dei modelli di apprendimento automatico nel settore bancario attraverso la XAI Cos’è la Explainable AI [...]

Dal Fmi, positive le stime del Pil italiano per il 2022, ma il quadro mondiale peggiora

Il digitale potrà davvero risollevare le sorti dell’economa mondiale? Dal Fmi, positive le stime del Pil italiano per il 2022, ma il quadro mondiale peggiora L'analisi del mercato [...]

Dall’Open Banking all’Open Finance: in che modo la digitalizzazione sta cambiando il panorama dei servizi finanziari

Dall’Open Banking all’Open Finance: in che modo la digitalizzazione sta cambiando il panorama dei servizi finanziari L’Open Finance, evoluzione dell’Open Banking, consiste nell’applicazione dell’Open Innovation al settore finanziario [...]

Gender Tech gap: responsabilità aziendale o problema socio-culturale?

Gender Tech gap: responsabilità aziendale o problema socio-culturale? Abbiamo chiesto ad Eva Pasqualini, Managing Partner, Direttore HR e Condirettore Commerciale di Technode, se il Gender Tech Gap è [...]

Greenwashing: come difendersi dai falsi green

Greenwashing: come difendersi dai falsi green Oggi il tema della sostenibilità ambientale è estremamente attuale e molte sono le aziende che stanno adeguando i propri processi e produzioni in ottica [...]

Le 8 competenze chiave di un bravo programmatore

Le 8 competenze chiave di un bravo programmatore Non basta saper programmare e scrivere righe di codice, per essere dei bravi programmatori sono oggi necessarie molte altre qualità. [...]